机器学习自2012年起热门至今,AI如今的发展也如火如荼。机器学习是计算机视觉可应用的一种解决方式。而当车载摄像头用上AI时,对CIS技术要求也随之改变,传统CIS还能担当“重任”吗...

“车载摄像头”本身是指代并不算明确的词,因为如今的汽车搭载越来越多的摄像头,而不同作用的摄像头,其规格和标准又是不尽相同的。Yole Developpement曾将车载摄像头大致分成了ADAS摄像头、视觉摄像头(如环视、前视、盲点监测等)、车舱内摄像头(如驾驶员监测、手势UI、存在检测等)、CMS(Camera Mirror System)、AV自动驾驶(前视、环视摄像头等)。

这个分类似乎是有些交叠的,但大方向上车内与车外的摄像头有差别,而让人看的摄像头与纯粹用于数据分析的摄像头又有差别。打个比方,手机摄像头拍的照片要求拍得好看,是要发朋友圈的;而车载摄像头要以“拍得到”为最高准则。

汽车上的摄像头按照是否给人看,也可以分成两大类。文首提到视觉摄像头即视觉应用是需要给人看的,像是电子后视镜、某些环视系统。还有一类是计算机视觉(机器视觉),应用于自动驾驶、自动泊车,这种摄像头所摄画面价值更不在于给人看,而是做数据分析。

本文主要探讨的是后一类车载摄像头(以及与智慧交通相关话题的摄像头)。ADAS与自动驾驶方向的许多摄像头都属于这一类,在这种情况下以人的视觉友好性为目的的图像处理,就没有价值了——计算机视觉(CV)就是指,以图像或视频为输入,输出的则是距离、色彩、形状、对象分类、语义分割等属性信息。计算机视觉所期望达成的是理解看到的世界(虽然当前的计算摄影实则也有一部分这种属性)。

在计算机视觉领域,AI成为一个不得不谈的话题:计算机视觉因此能够实现更快速和准确的图像分类、目标检测、目标跟踪、语义分割等。

当车载摄像头(主要是ADAS与AV相关的摄像头)应用于计算机视觉时,图像传感器有了哪些新的发展方向和技术要求。我们知道,计算机视觉如今与AI有着这么大的关联,换个角度看,也可以理解为车载摄像头采用AI技术时,图像传感器有了哪些新的发展。

车规级图像质量要求严苛

越来越多的图像传感器制造商,都愈发注重在AI时代下的发展。比较具有代表性的是安森美、思特威、意法半导体等图像传感器厂商普遍在宣传自家的全局曝光CMOS图像传感器,并且将其作为机器视觉的必要技术。因为在拍摄高速运动的对象时,唯有全局快门(Global Shutter)才能确保将对象拍清楚,才能实现准确的计算机视觉分析。

虽然这些并非全部面向车载摄像头,但也能管中窥豹地发现ADAS/AV摄像头对于图像传感器而言意味着什么。今年的中国IC领袖峰会上,思特威副总经理欧阳坚发表题为“以CMOS图像传感器创机器智视芯格局”的主题演讲,其中就提到了包括全局快门在内的多项新技术。

不过厂商从个体技术发展角度来谈车载摄像头的图像传感器技术要求,恐怕不够全面。从更全面的角度来理解这个问题,应当看一看标准和规范。市面上已有的标准似乎还是很多的,不过当前比较知名的汽车相关的图像质量规范,应该是IEEE P2020与ISO16505。从中应该可以部分发现,如今的车载图像传感器,到底有哪些技术要求。

ISO16505针对的主要是人眼视觉相关系统质量的规范,比如说电子后视镜、环视系统等;不对人眼可见的机器视觉部分是非强制的。很早之前,Imatest创始人曾公开嘲笑过ISO16505,认为这是不熟悉图像质量测试的人开发的(虽然这可能与Imatest实际参与IEEE P2020有关)。那么我们就来看看P2020。

IEEE P2020对于人眼视觉和机器视觉应用都有对应的规范,但这类规范推进的速度似乎还是比较缓慢。2018年9月发布的IEEE P2020 Automotive Imaging White Paper白皮书提到汽车摄像头图像质量尚未被完全定义好,诸多关键指标不明确;我们在IEEE官网看到,P2020目前似乎仍停留在这一步。不过这份白皮书列举了现有的一些图像质量规范,与车用摄像头实际需求之间存在的差异。这其中的一部分对于图像传感器(以及整个摄像头系统)而言就提出了新的思考,相比ISO16505也多出高动态范围、veiling glare等的测试。

其中包括Tonal Response(动态范围、SNR、低光照表现、Chroma shading)、Spatial Response(解析力、锐度、景深、纹理、运动模糊)、Temporal Response(Flicker/频闪)、Spectral Response(光谱量子效率、演色性、交通相关色彩区分性)、光学伪像(镜头眩光、鬼影、veiling glare/杂光、镜头色差、杂散光)、噪声、不均匀性(PRNU等)、热性能(高温下的SNR、分辨率等的变化)、功能表现(自动曝光、自动白平衡控制)、系统(多摄像头系统)、其他(镜头畸变、HDR多重曝光等)。

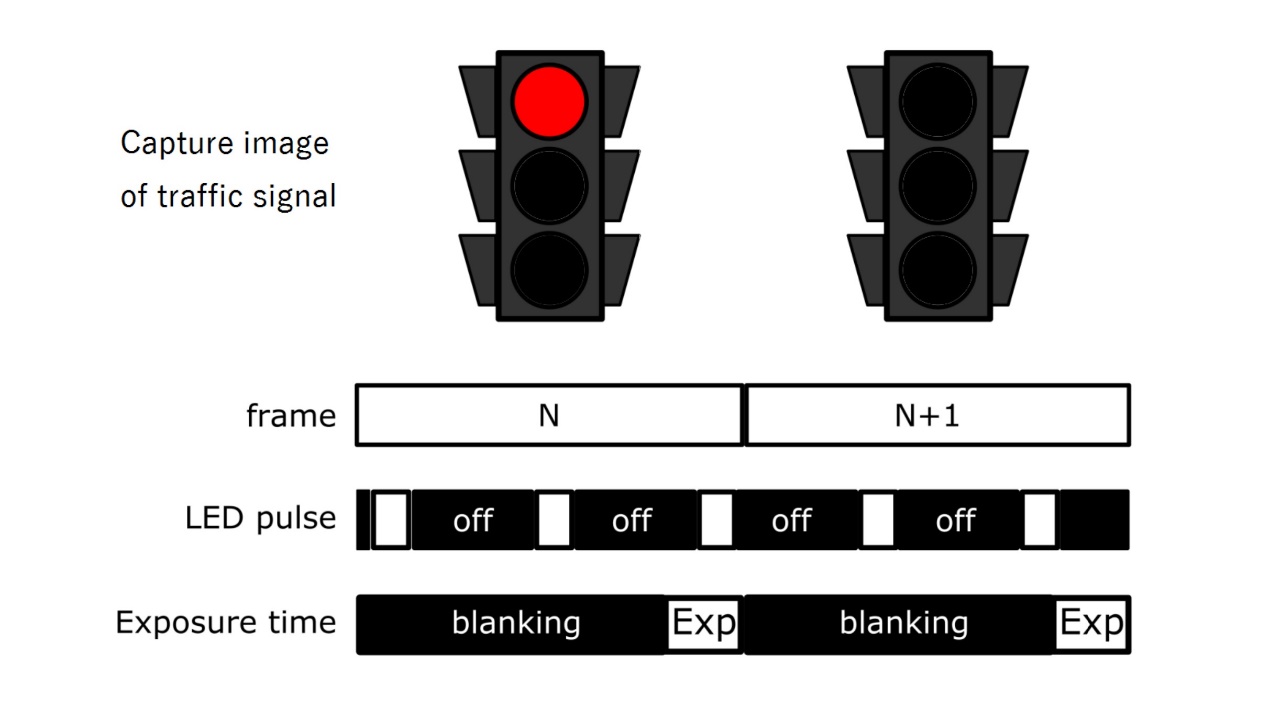

与此同时,P2020明确包含7个工作组,还是多少能够看到未来的趋势。与本文探讨的话题比较相关的有几个。其一是工作组1研究LED flicker standards,也就是LED频闪。欧阳坚在此前的演讲中也提过,“交通领域会遇到LED灯,红绿灯时高频闪烁的LED灯,如果不对高频闪烁的频率做处理,抓拍的信息就是残缺不全的。”人眼对于频率高于90Hz的闪烁不会有所察觉,但对图像传感器而言,曝光时长与LED光源调制信号产生一些错位时,就产生了频闪信息捕捉不全的问题。

这一点实则也是思特威、OmniVision这类图像传感器厂商研究的重要课题之一,虽然可能并非单纯面向车载领域。而P2020工作组1针对这种频闪,所做的工作包括阐明flicker产生的原因和细节;列举flicker出现的情况和潜在影响;定义flicker的测试方法和关键测试指标;定义flicker对人类视觉/机器视觉影响的客观测试指标。

其二,P2020明确的工作组3研究针对计算机视觉的图像质量(Image quality for computer vision)。其方向主要更偏系统级测试。相比EMVA1288这种更偏单个组件的测试,系统级测试对于实际应用是更有价值的。前面提到许多图像质量规范,比如其中的一些光学伪像、多摄像头系统就不只是摄像头乃至后端计算,其中一个组件的问题。

对车载图像传感器的技术需求有哪些?

要将所有标准规范中提及的测试项悉数列出还是不现实的,所以我们根据图像传感器企业目前着力的宣传点、新标准中针对车载摄像头新出现的部分来尝试总结ADAS/AV机器视觉对于图像传感器而言,提出了哪些要求,又有哪些新的发展方向。这里只讨论图像质量,不探讨车规级本身对于电子元器件在温度、天气等方面的严苛要求。

2018年,Smithers曾撰写过一份题为Autonomous Vehicle Image Sensors to 2023 – a State of the Art Report(到2023年自动驾驶汽车图像传感器 – 前沿报告)的报告。除了未来全自动驾驶将变得更依托于机器视觉,面向人类视觉的图像增强要求越来越低之外,还提到了几个趋势:

(1)达到140dB的动态范围,800万像素单目分辨率、200万像素立体视觉相机,超过60fps的帧率,高灵敏度;

(2)在0.001lux照度下,曝光时间不大于1/30秒的情况下,信噪比大于1;

(3)HDR高动态范围的同时,要求运动伪像更少;

(4)LED flickering问题消除。

这几点实则都不出意外,也是当代图像传感器厂商普遍在努力的方向,包括图像传感器自身的高动态范围、更高的分辨率、帧率,以及低照度下的灵敏度和低噪声。虽然报告中列举的部分参数还有些超前,现在的图像传感器制造商在这些目标的实现上,却都有自己的杀手锏。比如针对低光照环境,不少厂商在变革像素结构,同时开始采用双增益转换来兼顾白天和夜间场景。

这里比较值得一提的是趋势中提到的后两点。首先是HDR高动态范围,以及要求更低的运动伪像。其中HDR是车载摄像头所需实现的基本特性。毕竟当场景光比很大时,如果摄像头拍摄的画面有部分区域过曝或欠曝,计算机视觉分析工作就无法拿到对应的数据。从图像传感器的角度,实现HDR有多重曝光、双增益、大小像素分离,以及提高像素阱容等方法。

时域多重曝光的HDR方案在成像领域很常见,但在ADAS/AV方向上的适用度正逐步降低——因为车载摄像头要求画面不能有运动伪像,且必须抑制LED频闪。所以像思特威这样的厂商,开始倾向于采用单帧空间域多曝光的方案,典型的方法像是隔行多曝光:图像传感器上每两行为长曝光,两行为短曝光。ISSCC曾收录过思特威有关单帧HDR技术的论文。

图1,来源:思特威

另外抑制运动伪像一个重点就是全局曝光(或全局快门)。全局曝光也是现在几乎所有图像传感器制造商都在争夺的技术高地。传统卷帘快门(rolling shutter)因为采用逐行曝光的方式,拍摄高速运动物体时会有果冻效应(图1)。全局快门是让所有像素同时开始和结束曝光,也就规避了这种形式的影像失真。

索尼的Pregius全局快门传感器比较知名——ISSCC曾收录过索尼一篇每个像素都应用独立ADC的论文(像素级互联),这是快速读出实现全局快门的技术之一;OmniVision也有类似的技术介绍。索尼今年发布的第四代全局快门图像传感器终于也用上了BSI背照式技术,减小了像素尺寸。此前思特威在宣传中也提到,思特威是“全球为数不多率先将全局曝光和BSI技术融合的公司之一”。

图2,来源:IEEE P2020 Automotive Imaging White Paper

至于前文就提到的LED频闪消除(图2),这两年思特威、OmniVision都在不遗余力地宣传自家的图像传感器LED闪烁抑制技术。毕竟在自动驾驶、智慧交通领域,LED频闪导致摄像头捕捉到的交通标志、红绿灯读秒信息不全,会导致后端AI系统的误判。

一般来说,LED频闪抑制可以通过保持LED频闪与图像传感器快门同步的方式,问题是不同LED规格不一致,所以这种理论上的方案是不可行的。另外也可以通过HDR,在捕捉LED灯的画面时,确保能够用更长的曝光时间来捕捉更全面的信息。图像传感器厂商应用的都是这个大思路,虽然在具体实施上存在差别,例如OmniVision应用的是大小分离像素。

机器视觉感知未来趋势已定

从更偏系统的角度来看,大概还有一些技术趋势是值得一谈的。比如在传感器角度,车载领域各种传感器的融合会是个趋势,不仅是多摄系统,还可能是不同类别视觉传感器的融合,比如LiDAR与摄像头融合的传感器;还有RGB-IR传感器,为图像传感器融入红外感知能力(如果把传感器探讨范围扩展到IR传感器,可能还涉及到近红外响应增强等技术趋势,SWIR红外摄像头等)。

从整个成像/视觉系统的角度看,图像传感器将融合部分边缘算力,可能也会成为一个趋势。比如索尼就将AI边缘计算与图像传感器做了结合(IMX500);SK hynix去年也在新闻稿中提到,基于先进半导体制造工艺,堆栈式传感器中,将一个简单的AI硬件引擎加入到传感器下层的ISP中,已经是可行的了……虽然这些暂时还不是面向汽车市场的。

思特威前两年推出AISENS传感器芯片平台,就是“感知与计算一体的通用AI传感器芯片平台”,此前思特威也提及以3D堆叠的方式将数据处理die与传感器die封装到一起。这个平台如今似乎正趋于进一步的商用化。

去年Yole Developpement发布了一份题为《2019图像信号处理器与视觉处理器市场与技术趋势》的报告。该报告明确提到:“AI彻底改变了视觉系统中的硬件,对整个行业都造成了影响。”“图像分析增加了很多价值。图像传感器供应商们开始对将软件层集成到系统中感兴趣。如今图像传感器必须跳出单纯的捕获图像这一能力之外,再对图像做分析。”

2019年,EE Times曾发表过一篇题为ADAS: Key Trends on ‘Perception’的文章。这篇文章从更偏系统的角度谈了ADAS车载感知系统的发展趋势,建议阅读。

最后想简单谈谈以Prophesee为代表的基于事件的视觉传感器技术。下期《电子工程专辑》的精英访谈即是采访Prophesee CEO Luca Verre,其中相对详细地介绍了这类神经形态视觉技术。这种传感器的特色在于不受帧率限制(可实现等效10000fps的帧率),以及仅在场景中的对象发生动态变化时,才记录信息。

其优势在于产生数据量少、反应速度快、可实现高动态范围。而且这种技术天然地适用于机器视觉,Luca Verre在接受采访时说:“在机器视觉领域,我们认为基于事件的视觉传感器是可以替代传统基于帧的图像传感器技术的。而在成像领域,传统图像传感技术本身是没有问题的。”机器视觉领域的变革,大概还会有一波全新的浪潮。

原文发表于《国际电子商情》姊妹刊《电子工程专辑》,2021年5月